Как Apple планирует следить за пользователями

В начале августа 2021 года компания Apple провела брифинг для прессы, в ходе которого анонсировала новую систему идентификации фотографий, содержащих сцены насилия над детьми. Хотя цели Apple, безусловно, благие — борьба с распространителями детской порнографии, — компания немедленно подверглась критике.

До этого Apple потратила много усилий, чтобы создать имидж производителя, который заботится о приватности пользователей. Ожидаемые нововведения в iOS 15 и iPadOS 15 уже нанесли этой репутации серьезный ущерб, но сдаваться компания не намерена. Что именно произошло и как это отразится на обычных владельцах айфонов и айпадов? Давайте разбираться.

Что такое CSAM Detection

В общих чертах планы Apple описаны на сайте компании. Компания разработала систему, получившую название CSAM Detection и предназначенную для поиска на устройствах пользователей «материалов сексуального насилия над детьми» — то есть тех самых CSAM (эта аббревиатура расшифровывается как Child Sexual Abuse Material).

Хотя термин «детская порнография» обозначает то же самое, CSAM считается более корректным определением, по мнению организации NCMEC (National Center for Missing and Exploited Children), которая занимается поиском и спасением пропавших и эксплуатируемых детей в США. Именно она поставляет Apple и другим технологическим компаниям информацию об известных фотографиях со сценами насилия.

CSAM Detection была анонсирована вместе с некоторыми другими фичами, расширяющими функциональность родительского контроля на мобильных устройствах Apple. Например, родителям будут присылать уведомление, если ребенку в мессенджере Apple пришлют порнографическую картинку.

Из-за одновременного анонса сразу нескольких технологий произошла путаница, и у многих возникло ощущение, что Apple теперь будет следить за всеми и всегда, но это не совсем так. Далее в этом материале мы будем говорить только о технологии CSAM Detection.

Когда будет запущена CSAM Detection

CSAM Detection станет частью мобильных операционных систем iOS 15 и iPadOS 15, которые этой осенью станут доступны для всех владельцев современных iPhone и iPad (iPhone 6S, iPad пятого поколения и более поздних). Хотя функция CSAM Detection в теории будет доступна на мобильных устройствах Apple по всему миру, полноценно работать эта система пока будет только в США.

Как будет работать CSAM Detection

Важно понимать, что CSAM Detection работает только в связке с iCloud Photos. Это часть облачного сервиса iCloud, которая загружает на серверы Apple все фотографии со смартфона или планшета и делает их доступными на других устройствах пользователя.

Если выключить синхронизацию фотографий в настройках, перестанет работать и CSAM Detection. Значит ли это, что фотографии сверяются с криминальной базой данных только в облаке? Нет, не совсем так. Система намеренно сделана достаточно сложной, так как Apple пытается обеспечить необходимый уровень приватности.

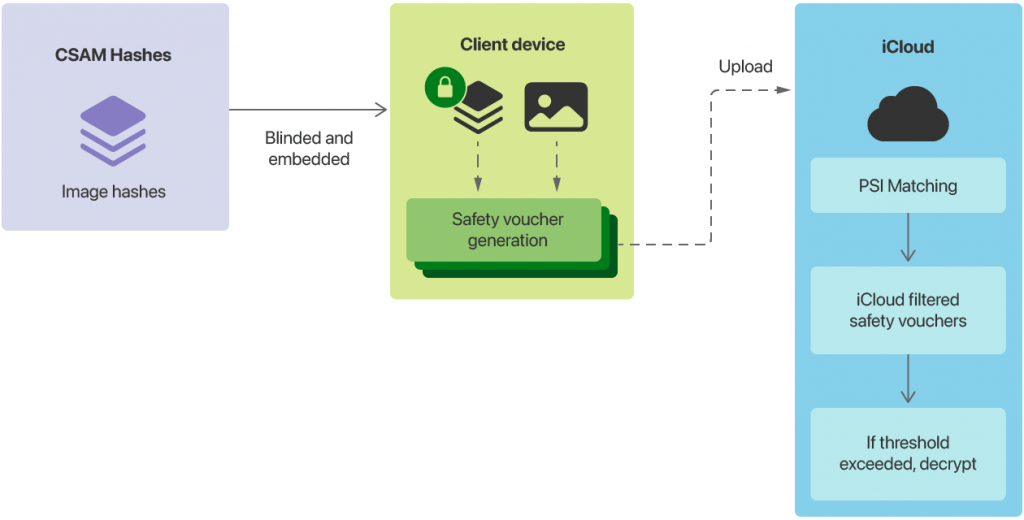

На сайте Apple есть документ, описывающий работу CSAM Detection. Если все предельно упростить, работает она так. Первоначальное определение, соответствуют ли фотографии пользователя снимкам из базы вышеупомянутой детской организации NCMEC — или других подобных организаций, — происходит на устройстве.

Для этого используется технология NeuralHash, по сути создающая цифровой идентификатор фотографии в зависимости от ее содержимого. Если идентификатор совпадает с таковым в базе известных снимков с эксплуатацией детей, информация об этом отправляется на серверы Apple. Там проводится еще одна проверка, и только после нее совпадение фиксируется «официально».

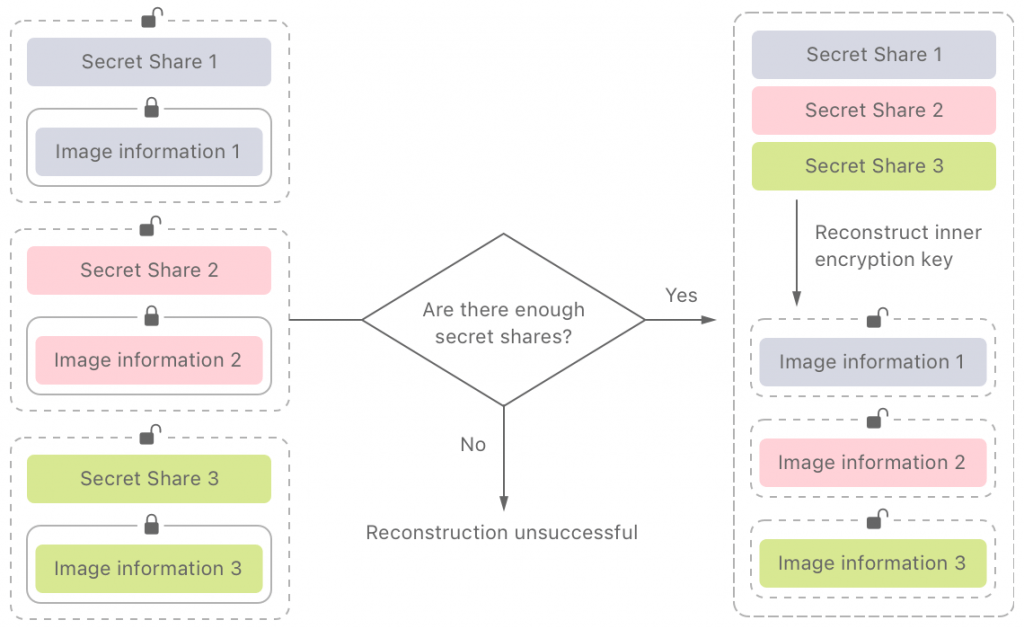

Еще один элемент системы — криптографический протокол Private Set Intersection. Он шифрует результаты работы CSAM Detection так, чтобы расшифровать их на стороне Apple можно было бы только в случае выполнения ряда критериев. Это по идее должно предотвратить использование системы за пределами заданных ограничений — то есть злоупотребление сотрудником компании или выдачу по требованию государственных органов.

13 августа Крейг Федериги, старший вице-президент Apple по разработке ПО, в интервью Wall Street Journal озвучил самое главное ограничение для протокола Private Set Intersection. Чтобы в Apple «сработала тревога», 30 фотографий должны совпасть с таковыми из базы NCMEC. До этого порога, как показано на схеме выше, система Private Set Intersection просто не даст расшифровать набор данных — информацию о работе системы CSAM Detection и сами фото. Такой достаточно высокий порог срабатывания, по словам Apple, дает очень мало шансов на ложное определение — якобы такое может произойти только «в одном случае из триллиона».

Что происходит в случае срабатывания системы? Сотрудник Apple вручную проверяет данные, убеждается, что на телефоне пользователя действительно хранится детское порно, и уведомляет правоохранительные органы. Так как система в полную силу пока будет работать только в США, уведомление будет отправлено в тот самый центр NCMEC, спонсируемый американским Департаментом юстиции.

Что не так с CSAM Detection?

Прежде чем ответить на этот вопрос, давайте разделим возможную критику действий Apple на две категории. Первая — это общие претензии к Apple, когда сам подход кому-то кажется неправильным. Вторая — технические факты, подтверждающие уязвимость заявленного протокола, то есть конкретные доказательства, что его можно использовать не только так, как обещает компания.

Конкретных фактов, что Apple допустила какую-то техническую ошибку, пока немного (о них поговорим ниже), а вот претензий общего характера было высказано более чем достаточно.

К примеру, они подробно описаны в публикации фонда Electronic Frontier Foundation. По версии EFF, компания Apple так или иначе встраивает бэкдор в устройство, внедряя сканирование на стороне клиента. Именно эта концепция критиковалась фондом EFF еще в 2019 году.

Почему это плохо? Допустим, у вас есть устройство, данные на котором, по утверждению Apple, полностью зашифрованы. Вы можете получить к ним доступ по отпечатку пальца или паролю, и больше этого сделать не может никто. И тут производитель добавляет какую-то функцию, которая сканирует часть данных на вашем устройстве, и если ей вдруг не понравится содержимое, может сообщить об этом «куда следует».

Сейчас речь идет о детской порнографии, но раз уж такой механизм существует, где гарантия, что его нельзя будет перенацелить на другой контент?

Это, если хотите, критика политического характера. Проблема заключается в том, что общественного договора, определяющего баланс между безопасностью и приватностью, пока нет. Все мы — от чиновников, производителей устройств и разработчиков софта до правозащитников и обычных пользователей — пытаемся определить этот баланс прямо сейчас.

Претензии правоохранительных органов о сложностях в поимке преступников и сборе доказательной базы из-за повсеместного внедрения шифрования понятны. Опасения по поводу массовой цифровой слежки тоже очевидны. Отношение к поступку Apple каждый может составить исходя из своей картины мира.

Потенциальные проблемы реализации CSAM Detection

Но подождите, это еще не все. Любой программный код приносит новые уязвимости. Ладно государство, а не сможет ли воспользоваться уязвимостями системы CSAM Detection киберкриминал? Когда речь идет о шифровании данных, это естественное опасение — если ослабить защиту информации для благих целей, этой слабиной могут воспользоваться и во вред. На этот вопрос точного ответа пока нет, независимый аудит кода CSAM Detection только начался, и может продлиться очень долго. Но кое-что уже удалось узнать.

Как выяснилось, код, позволяющий сравнивать фотографии с неким «эталоном», присутствовал в iOS (а также в macOS) начиная с версии 14.3. Не исключено, что именно он будет частью системы CSAM Detection. Уже написаны утилиты, позволяющие экспериментировать с алгоритмом поиска совпадающих картинок, и в том числе находить вот такие коллизии: две картинки ниже по версии алгоритма Apple NeuralHash имеют одинаковый цифровой идентификатор, при этом они очевидно разные.

Если удастся вытащить ту самую базу идентификаторов «криминальных фотографий» можно подготовить «невинные» фото, которые тем не менее вызывают срабатывание. Большое количество ложных срабатываний на стороне Apple может сделать систему CSAM Detection нежизнеспособной. Скорее всего, именно поэтому Apple разделила детектирование, и часть алгоритма работает только на стороне сервера.

Еще один анализ посвящен системе Private Set Intersection, которая задокументирована достаточно подробно. Претензия к ней следующая: даже до порога срабатывания система PSI передает на серверы Apple достаточно много информации. В статье допускается такой сценарий: все данные о пользователе на стороне Apple запрашиваются правоохранительными органами, и они уже могут делать выводы исходя из имеющейся информации. Делается намек, что даже ложные срабатывания в теории могут привести к визиту полиции.

Впрочем, это пока только первые попытки независимого исследования CSAM Detection. Насколько они в принципе будут успешными, во многом зависит от самой Apple — готова ли будет эта компания обеспечить достаточную прозрачность работы спорной системы, вплоть до выкладывания исходного кода. А Apple, как известно, старается держать свои секреты при себе.

Что внедрение CSAM Detection означает для обычного пользователя

Современные устройства настолько сложны, что определить истинную степень их защищенности — то, как они выполняют данные производителем обещания, — очень сложно. Приходится доверять (или не доверять), основываясь на репутации компании.

Однако важно помнить об одном принципиальном моменте: CSAM Detection работает только при загрузке фотографий в iCloud. Apple специально сделала именно так, чтобы иметь аргумент против части претензий. Если вы не загружаете фото в облако — ничего никуда не отправляется.

Вероятно, многие помнят известный конфликт между Apple и Федеральным бюро расследований США, который произошел в 2016 году. Тогда ФБР попросила у Apple помощи в разблокировке iPhone 5C, принадлежавшего террористу, расстрелявшему 14 человек в Сан-Бернардино, Калифорния. Просьба была сформулирована так: может ли Apple написать софт, который позволил бы снять пароль и расшифровать данные на телефоне?

Apple тогда ответила резким отказом: по сути от компании требовали написать бэкдор, с помощью которого можно было разблокировать и телефон террориста, и любой другой. Тогда ФБР отступила и взломала устройство при содействии сторонней компании, используя уязвимость в ПО. В том случае Apple заработала репутацию компании, которая борется за права своих клиентов.

Однако в той истории был один нюанс: копию данных с телефона в iCloud компания Apple передала по запросу властей спокойно и без всякой драмы. На самом деле компания имеет доступ практически к любым данным пользователей, которые загружаются в облако. Кое-что хранится с использованием сквозного шифрования (к примеру, пароли в Keychain и платежные данные). Но большая часть информации шифруется только для защиты от несанкционированного доступа — то есть, грубо говоря, от взлома серверов компании. Так что по запросу властей компания может эти данные расшифровать.

И это, пожалуй, самый интересный сюжетный поворот истории с CSAM Detection. Компания могла бы просто сканировать вообще все фотографии в iCloud Photos, так же, как это делают Facebook, Google и многие другие поставщики облачных сервисов. Apple решила создать более элегантный механизм, который помог бы ей избавиться от обвинений в массовой слежке за пользователями. Но достигла ровно противоположного эффекта — навлекла на себя еще больше критики за сканирование на стороне клиента.

В итоге для обычного пользователя вся эта драма мало что поменяла. Если вы обеспокоены защитой ваших данных, следует критично относиться к любому облачному сервису. Данные, которые вы храните только на вашем устройстве, все еще в безопасности. Своими действиями Apple посеяла обоснованные сомнения, будет ли так продолжаться и дальше, — но пока это открытый вопрос.